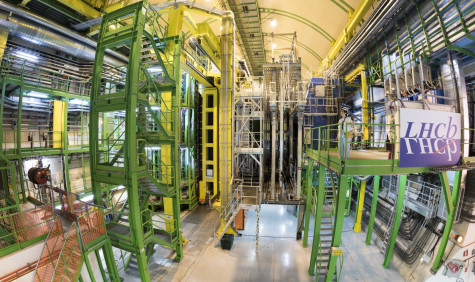

LHCb experiment spelonk | © 2016 CERN

SURF en leden bundelen krachten op het nieuwe gebied van quantum computing: van quark naar quantum

Miljarden botsingen 100 meter onder de grond

Elke seconde botsen er miljoenen deeltjes op elkaar bij het LHCb-experiment van CERN. De gegevens die door deze botsingen worden gegenereerd, zijn zo groot dat ze in real-time moeten worden gefilterd. Dit is een enorme rekenkundige uitdaging. Zowel door de grote hoeveelheden gegevens als door de complexiteit van de algoritmen achter de selectie van interessante gebeurtenissen.

Het probleem

De belangrijkste uitdaging bij het LHCb-experiment van CERN is de reconstructie van het spoor van deeltjes in real-time reconstructie. Door de hoge botsingssnelheden van de deeltjes bij de LHC (van ongeveer 40 MHz) kunnen de gegevenssnelheden oplopen tot meer dan 2 TB/s. Momenteel worden de gegevens in real-time gereconstrueerd en worden interessante gebeurtenissen "on the fly" geselecteerd, waardoor de datasnelheid tot ongeveer 5 KHz wordt beperkt. Bij de LHC met hoge lichtkracht zal het aantal gelijktijdige deeltjesbotsingen echter verzevenvoudigen, waardoor de online reconstructie van gebeurtenissen drastisch op de proef zal worden gesteld. De gegevens moeten zo snel mogelijk worden verwerkt om de gebruikers de nodige input voor hun analyse te geven.

Het doel: een kennisbank en proof-of-concept omgeving

In dit project zullen de Universiteit Maastricht, Nikhef, CERN en SURF een aantal specifieke uitdagingen voor het LHCb-experiment aanpakken om te bepalen welke elementen van de data-analyseketens (inclusief het genereren van gesimuleerde gebeurtenissen en de analyse daarvan) het meest geschikt zijn voor een quantumcomputingaanpak. Dit project heeft tot doel 1) state-of-the-art quantum computing benaderingen in hoge energie fysica te verkennen en te ontwikkelen, 2) een kennisbank op te zetten bij SURF en in Nederland en 3) te fungeren als een proof-of-concept omgeving om te experimenteren met nieuwe algoritmen op een schaal die realistisch is om computationele en algoritmische knelpunten te identificeren.

Wat achtergrond: wat gebeurde er na de oerknal?

LHCb is een experiment dat is opgezet om te onderzoeken wat er na de oerknal is gebeurd waardoor materie kon overleven en het heelal kon ontstaan dat we nu bewonen. Veertien miljard jaar geleden begon het heelal met een knal. Samengeperst in een oneindig kleine ruimte, smolt energie samen tot gelijke hoeveelheden materie en antimaterie. Maar toen het heelal afkoelde en uitdijde, veranderde de samenstelling. Slechts één seconde na de oerknal was antimaterie zo goed als verdwenen en bleef materie over om alles te vormen wat we om ons heen zien - van de sterren en sterrenstelsels tot de aarde en al het leven dat zij ondersteunt.